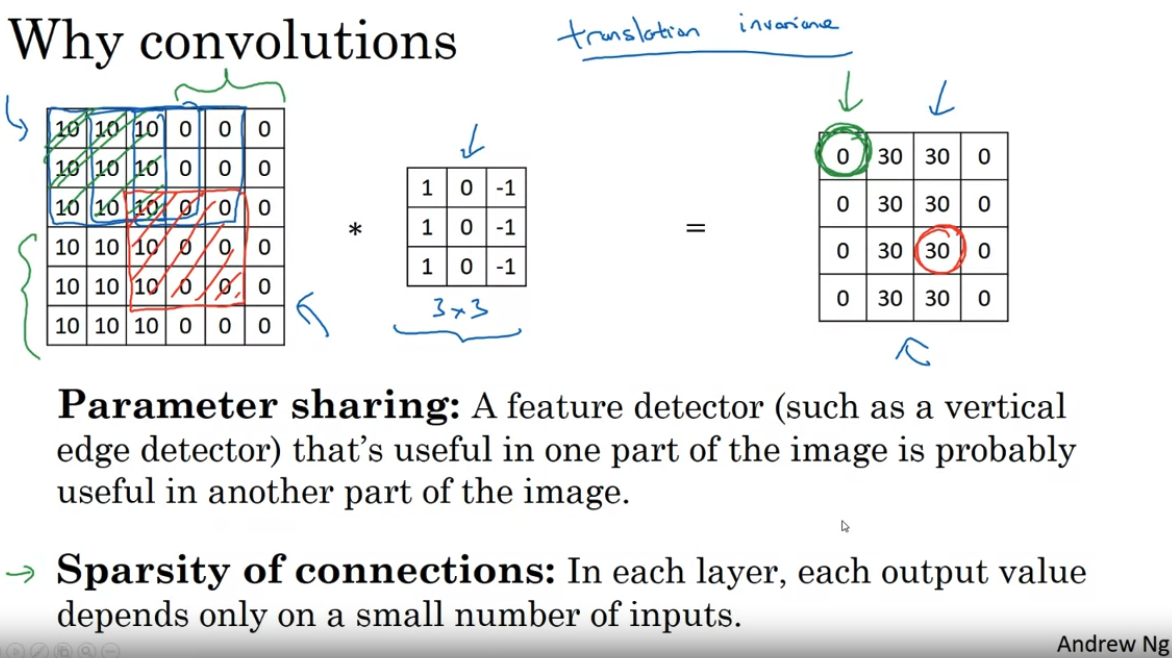

This post heavily relies on Andrew Ng's lecture: 컨볼루션 신경망DeepLearning.AI에서 제공합니다. 딥러닝 전문 과정의 네 번째 과정에서는 컴퓨터 비전이 어떻게 발전해 왔는지 이해하고 자율주행, 얼굴 인식, 방사선 이미지 판독 등 흥미로운 응용 분야에 익숙해www.coursera.orgAdvantages of Convolutional Layers Over Fully Connected LayersFollowing above example, if we use Fully-connected layer instead of Convolutional layer, we should connect 3,072 and 4,704 neurons.That is, the number..