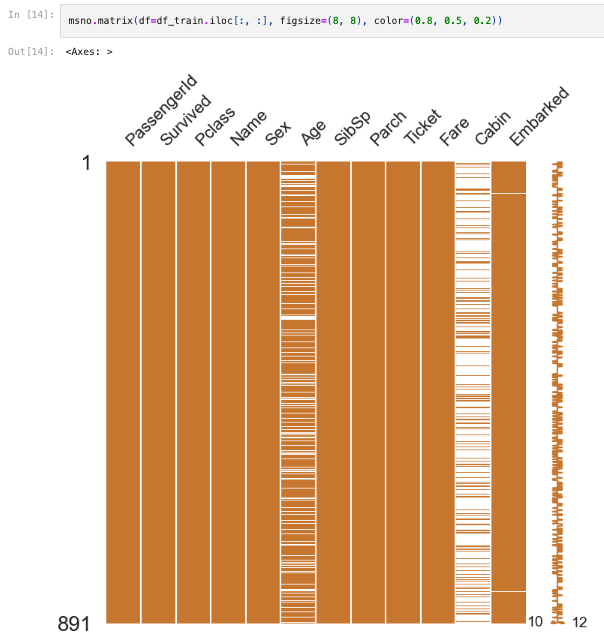

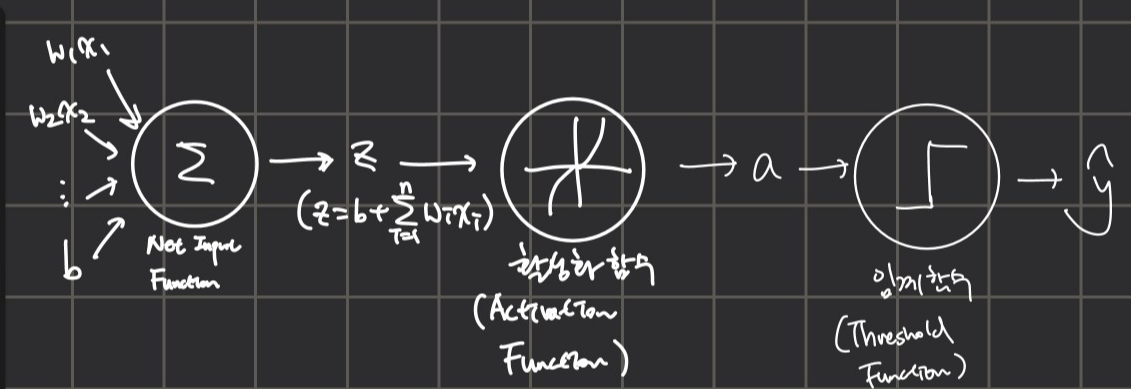

First competition following Yuhan Lee's kaggle curriculum. Binary classification competition using tabular data. First KernelEDA(Exploratory Data Analysis) written on Titanic competition by Yuhan himself.visualization tool used: matplotlib, seaborn, plotlydata analysis tool used: pandas, numpymachine learning tool: sklearncode: https://github.com/LDYWINNER/TIML/blob/main/kaggle-roadmap/binary-c..